En el mundo del Machine Learning, uno de los problemas más comunes al entrenar modelos es el overfitting, o sobreajuste. Este fenómeno ocurre cuando un modelo aprende demasiado bien los detalles y ruido de los datos de entrenamiento, hasta el punto de que pierde capacidad de generalización para nuevos datos.

¿Qué es el overfitting?

El overfitting sucede cuando un modelo se ajusta demasiado a los datos de entrenamiento, incluyendo patrones falsos o irrelevantes. Como resultado, el modelo tiene un excelente desempeño en los datos con los que fue entrenado, pero su precisión cae drásticamente cuando se enfrenta a datos nuevos.

Para entenderlo mejor, pensemos en un estudiante que memoriza todas las respuestas de un examen práctico en lugar de aprender los conceptos. Si bien podría obtener una calificación perfecta en ese examen, es probable que tenga dificultades al enfrentarse a preguntas nuevas sobre el mismo tema.

Este problema se agrava en modelos con una gran cantidad de parámetros, como las redes neuronales profundas, donde la sobreadaptación a los datos de entrenamiento puede impedir que el modelo generalice bien a datos no vistos previamente.

¿Cómo detectar el overfitting?

Al entrenar un modelo de Machine Learning, es crucial evaluar su rendimiento no solo en los datos de entrenamiento, sino también en un conjunto de datos de prueba o validación. Algunas señales de que un modelo está sufriendo de overfitting incluyen:

1. Alta precisión en entrenamiento, baja precisión en prueba: Si el modelo obtiene un 98% de precisión en el conjunto de entrenamiento pero solo un 60% en el conjunto de prueba, es una clara indicación de overfitting.

2. Curvas de Pérdida o Error Divergentes: Si la pérdida del conjunto de entrenamiento sigue disminuyendo mientras que la del conjunto de validación empieza a aumentar, el modelo ha empezado a sobreajustarse.

3. Mayor Complejidad del Modelo sin Mejora de Generalización: Modelos con muchas capas en redes neuronales o con demasiados parámetros pueden volverse demasiado complejos y capturar patrones irrelevantes.

4. Predicciones Extremadamente Precisas en Datos de Entrenamiento: Si el modelo predice perfectamente los datos de entrenamiento pero tiene dificultades con datos de prueba, es una señal de que ha memorizado en lugar de aprender.

El overfitting sucede cuando un modelo se ajusta demasiado a los datos de entrenamiento, incluyendo patrones falsos o irrelevantes. Como resultado, el modelo tiene un excelente desempeño en los datos con los que fue entrenado, pero su precisión cae drásticamente cuando se enfrenta a datos nuevos.

Estrategias para Evitar el Overfitting

Afortunadamente, existen diversas técnicas para reducir el riesgo de overfitting en un modelo de Machine Learning. Algunas de las más efectivas incluyen:

1. Obtener más datos

Cuantos más datos tengamos, más probabilidades de que el modelo aprenda patrones generales en lugar de detalles específicos del conjunto de entrenamiento. Añadir nuevos datos o utilizar técnicas de data augmentation puede ser una solución efectiva.

Además, asegurarse de que los datos sean representativos y diversos ayuda a mejorar la generalización del modelo. Técnicas como el aumento de datos sintéticos pueden ser útiles cuando la recolección de datos adicionales es costosa o inviable.

2. Regularización

La regularización introduce penalizaciones en los coeficientes del modelo para evitar que crezcan demasiado. Algunas técnicas populares incluyen:

- L1 (Lasso): Reduce ciertos parámetros a cero, promoviendo la selección de variables relevantes.

- L2 (Ridge): Reduce el impacto de parámetros extremos sin eliminarlos por completo.

- Dropout (en Redes Neuronales): Apaga aleatoriamente algunas neuronas durante el entrenamiento para prevenir dependencias excesivas en ciertos patrones.

- Batch Normalization: Ayuda a estabilizar y acelerar el entrenamiento al normalizar las activaciones de cada capa en redes neuronales.

3. Uso de validación cruzada (K-fold)

En lugar de dividir los datos una sola vez en entrenamiento y prueba, la validación cruzada (como la técnica k-fold) permite entrenar el modelo en diferentes subconjuntos de datos, asegurando que el rendimiento generalizado sea óptimo.

4. Early Stopping

Si se detecta que la pérdida en el conjunto de validación comienza a aumentar mientras que la del entrenamiento sigue disminuyendo, es un indicador de overfitting. Early stopping detiene el entrenamiento en el punto en que el modelo alcanza su mejor rendimiento en validación.

5. Reducción de la complejidad del modelo

Un modelo demasiado complejo puede captar patrones irrelevantes. Si un modelo tiene demasiados parámetros o capas, podría ser beneficioso simplificarlo para mejorar su capacidad de generalización. Además, el uso de técnicas como la poda de árboles en modelos de árboles de decisión puede reducir el sobreajuste.

6. Introducción de Ruido en los Datos

Agregar una pequeña cantidad de ruido a los datos puede ayudar al modelo a generalizar mejor, evitando que se aferre a patrones específicos. En redes neuronales, se pueden agregar técnicas como label smoothing, que evita que el modelo se vuelva demasiado confiado en una única predicción.

7. Balanceo de Datos y Normalización

Si los datos están desbalanceados (por ejemplo, en clasificación), el modelo podría aprender sesgos indeseados. Normalizar las entradas o aplicar técnicas como SMOTE (Synthetic Minority Over-sampling Technique) puede mejorar el rendimiento.

Además, la normalización de los datos, asegurando que todas las características estén en una escala similar, ayuda a modelos como regresión logística o redes neuronales a converger más rápido y evitar sesgos en las predicciones.

Conclusión

El overfitting es un problema común en Machine Learning, pero con las estrategias adecuadas, podemos minimizar su impacto y construir modelos más robustos. Desde la recolección de más datos hasta el uso de regularización y técnicas como early stopping, hay diversas formas de asegurar que un modelo no solo aprenda, sino que también generalice bien en datos nuevos.

En Skillnest, enseñamos a nuestros estudiantes a identificar y mitigar el overfitting a través de prácticas en proyectos reales. Además, fomentamos el aprendizaje con conjuntos de datos variados y experimentación con diferentes enfoques. Aprende con nosotros y lleva tus habilidades de Machine Learning al siguiente nivel:

Artículos relacionados

Cómo crear tu primer corto con IA (sin saber editar)

¿Alguna vez has soñado con dirigir una película pero te detiene el no saber usar programas complejos de edición o no tener una cámara profesional? El talento creativo no debería verse limitado por barreras técnicas o el dominio de herramientas complejas....

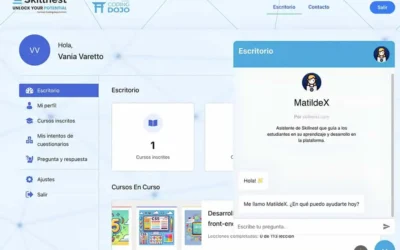

Edtech chilena Skillnest lanza MatildeX, un tutor con IA para preparar la PAES — Tekios

Miércoles 21 de enero, 2026 ¿Tus alumnos usan la IA como atajo o como tutor? Descubre cómo MatildeX transforma el uso de la inteligencia artificial en el aula para que los estudiantes desarrollen pensamiento crítico en lugar de solo buscar la respuesta...

Cómo utilizar Gemini para analizar tablas en Google Sheets

En la era del Big Data, no necesitas ser un experto en programación o un gurú de las matemáticas para entender qué dicen tus números. La llegada de Gemini a Google Sheets ha cambiado las reglas del juego, permitiendo que cualquier persona, sin importar su nivel de...